| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

- 딥러닝 실험 깃 버전관리

- 디자인 패턴

- 로스트아크

- 디자인패턴

- 자바 영화 api

- python

- 파이썬 경사하강법

- 인공지능 깃 버전관리

- 인공지능

- 딥러닝

- 대학원 월급

- Dehaze

- 의료 ai 대학원 월급

- 정규화

- 코딩테스트

- 영화 api

- MLP

- C# 프로젝트

- 대학원 급여

- 파이썬

- 자바 프로젝트

- 경사하강법

- 활성화 함수

- 백준

- 자바

- DCP

- 머신러닝

- pandas

- API

- 통계학

- Today

- Total

대학원 일기

딥러닝(Deep learning) 학습 방법 본문

비선형 모델 학습

비선형모델: 신경망(neural network)

각각의 행벡터 $o_{i}$는 행렬로 이루어져있는 $x_{i}$와 $W$라는 가중치의 행렬곱과 $b$라는 편향값을 더하여 $O$라는 출력값이 나온다.

- $d$개의 변수로 $p$개의 선형모델을 만들어서 $p$개의 잠재변수를 설명하는 모델을 볼 수 있다.

- 아래 그림에서는 x라는 변수가 o라는 결과값으로 갈 때, w(가중치)를 곱하고 b(편향값)를 더한다.

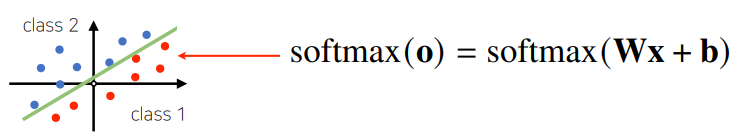

softmax 함수

- 선형 모델로 나온 출력값에 softmax를 통해 분류 문제를 해결한다.

- 소프트맥스(softmax) 함수는 모델의 출력을 확률로 해석할 수 있게 변환해주는 연산이다.

- 소프트맥스(softmax) 함수는 N개의 요소값을 가지는 벡터에서 각 요소 간 상대적인 확률을 구할 때 사용한다.

- Softmax(소프트맥스)는 입력받은 값을 출력으로 0~1사이의 값으로 모두 정규화하며 출력 값들의 총합은 항상 1이 되는 특성을 가진 함수이다.

- 소프트맥스 함수는 출력층에서 사용되는 함수이다.

- 분류 문제를 풀 때 선형 모델과 소프트맥스 함수를 결합하여 예측한다.

- 추론을 할 때에는 소프트맥스 결과값을 One hot encoder의 입력으로 연결하면 가장 큰 값만 True값, 나머지는 False값이 나오게 하여 이용 가능하다.

- 데이터를 추론할 때는 소프트맥스 함수를 사용하지 않고 원핫인코딩을 한다.(학습할 때는 softmax)

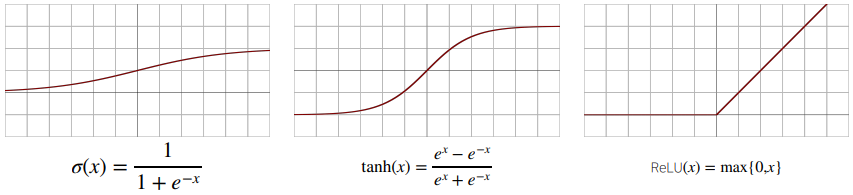

활성화 함수(activation function)

신경망은 선형모델과 활성화 함수(activation function)를 합성한 것.

- 활성함수(activationfunction)는 ℝ 위에 정의된 비선형(nonlinear) 함수로서 딥러닝에서 매우 중요한 개념이다.

- 활성화 함수를 쓰지 않으면 딥러닝은 선형 모형과 차이가 없다.

- 시그모이도(sigmoid) 함수나 tanh 함수는 전통적으로 많이 쓰이던 활성화 함수지만, 딥러닝에서는 ReLU 함수를 많이 사용한다.

대표적인 활성화 함수 종류

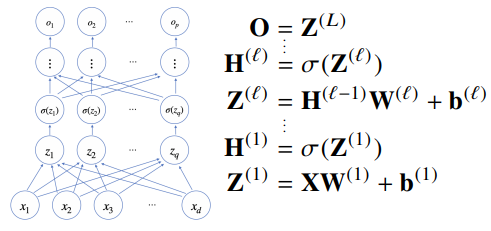

MLP(Multi Layer Perceptron)

- 딥러닝의 가장 기본적인 모델이다.

- MLP는 신경망이 여러층 합성된 모델이다.

- 입력층과 출력층 사이에 수많은 은닉층이 존재한다.

- 층이 많아질수록 목적함수를 근사하는데 필요한 뉴런(노드)의 숫자가 훨씬 빨리 줄어들어 좀 더 효율적으로 학습이 가능하지만, 그만큼 계산량이 많아진다. 그래도, 노드를 키우는 게 더 효율적이다.

- 입력층에서 출력층으로 가는 순차적인 신경망 계산을 순전파(forward propagation)이라고 한다.

역전파 알고리즘(Back propagation)

- 역전파(Back propagation)은 앞에 순전파 알고리즘과 반대로 각 층의 결과값을 얻고, 출력층에서 은닉층을 거치고 입력층으로 되돌아가면서 가중치(weight)와 편향값(bias)를 재조정(update)한다.

- 딥러닝은 역전파 알고리즘을 통해 각층에서 사용된 가중치($W$)와 편향값($b$)를 학습한다.

- 역전파(back propagation)은 역순($L$→1)으로 연쇄법칙(chain-rule)을 통해 그레디언트 벡터를 전달한다.

- 역전파 알고리즘은 합성함수를 미분하는 방식인 연쇄법칙(chain-rule)을 기반으로 한 자동미분(auto-differentiation)를 사용한다.

'AI > 인공지능 기초' 카테고리의 다른 글

| pandas II (0) | 2022.02.13 |

|---|---|

| 선형(Linear) 데이터와 비선형(Non-linear) 데이터의 차이 (0) | 2022.02.03 |

| pandas(1) (0) | 2022.01.31 |

| 경사하강법(Gradient descent)(2) (0) | 2022.01.29 |

| 경사하강법(Gradient descent) (0) | 2022.01.27 |